近来国产AI大模型DeepSeek爆火出圈,登顶中俄AppStore下载榜,还在性能、性价比上碾压了ChatGPT和GoogleGemini等硅谷大鳄,直接杀入科技圈C位,成为现象级应用!

但是,不少男子伴在使用的时侯,时常会出现响应迟钝甚至宕机的情况

这可如何办?

庆幸的是,DeepSeek是一个开源模型,这意味着我们可以将它布署在自己的笔记本上,便于随时使用!

明天就跟你们分享一下,怎样将DeepSeek布署在你的笔记本上

Step1:Ollama环境搭建

首先我们须要安装Ollama,Ollama是一个用于本地管理和运行大模型的工具,还能简化模型的下载和调度操作。

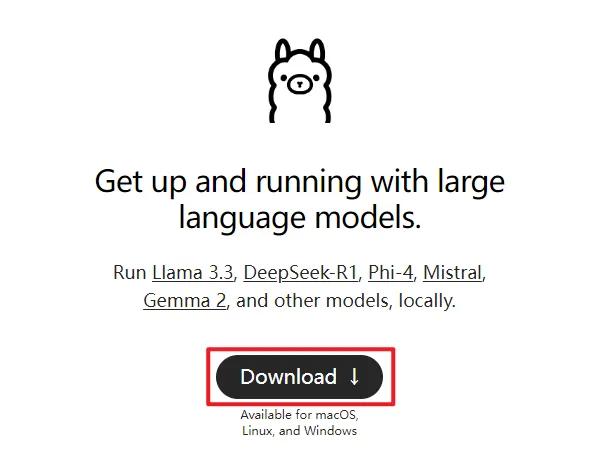

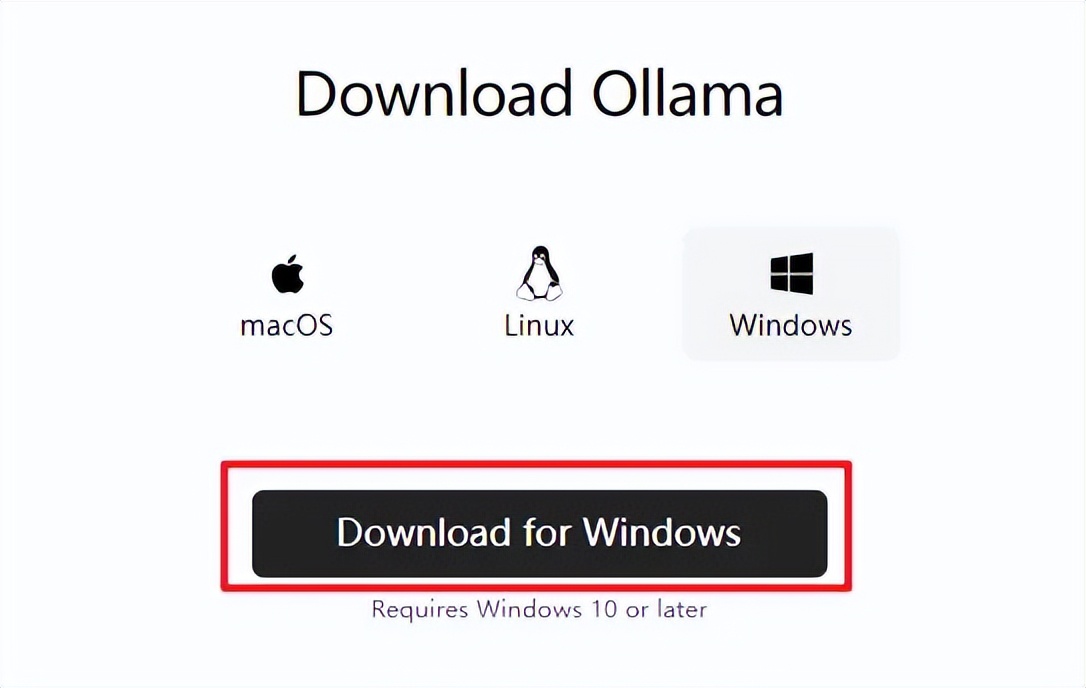

步入Ollama官网()。

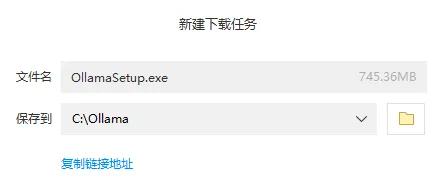

点击【Download】,选择适宜自己系统的版本(Windows/mac/Linux)。

下载后点击安装,等待安装完成即可。最好安装到C盘,安装在其它盘,否则安装后可能须要重新配置环境变量。

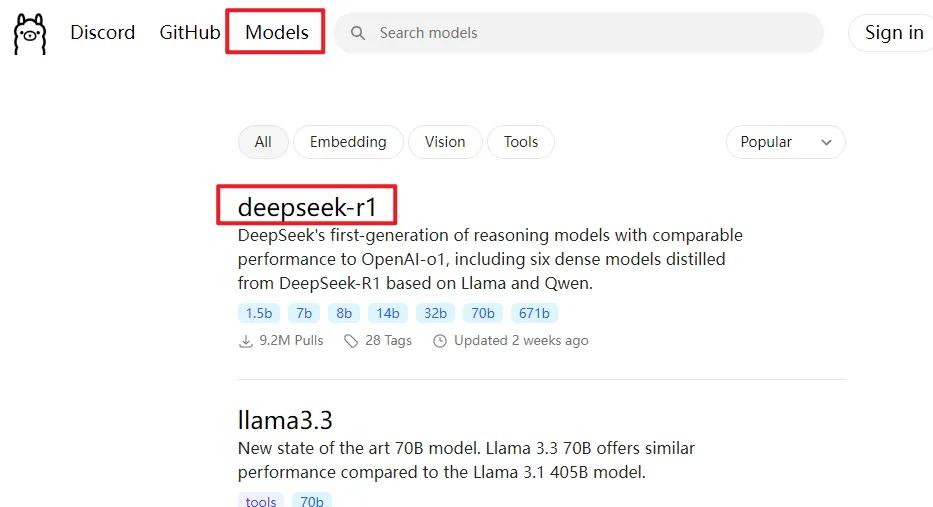

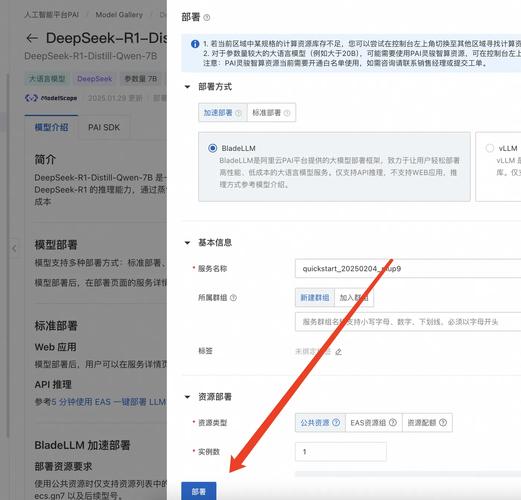

Step2:选择要安装的模型

接着返回Ollama官网,点击右上角的【Models】w3c linux,再选择【deepseek-r1】。

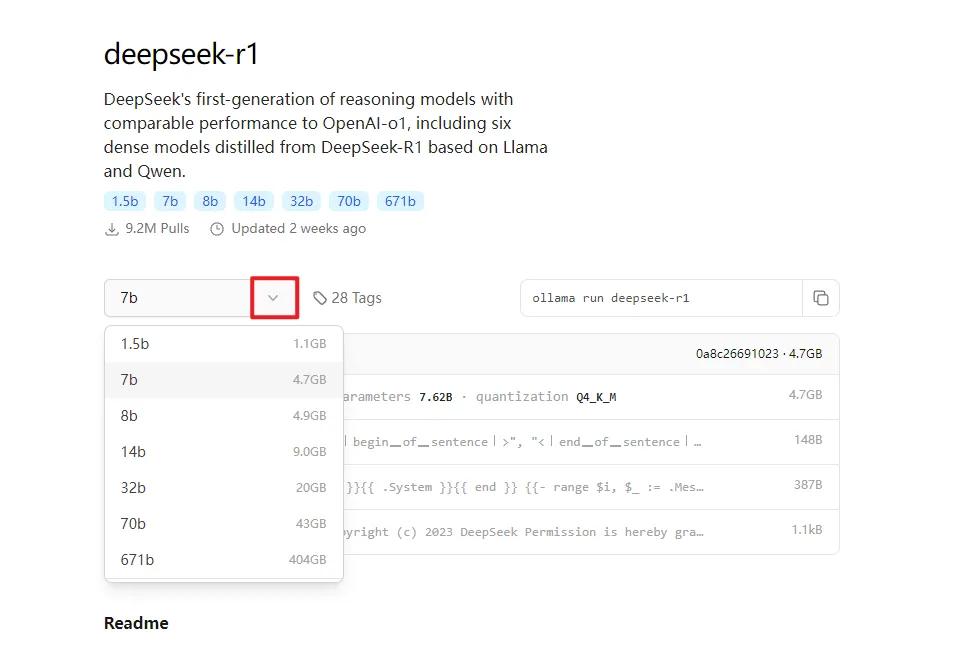

下拉可以见到多个参数版本,数字越大,模型参数越多,性能越强,对内存要求越高。

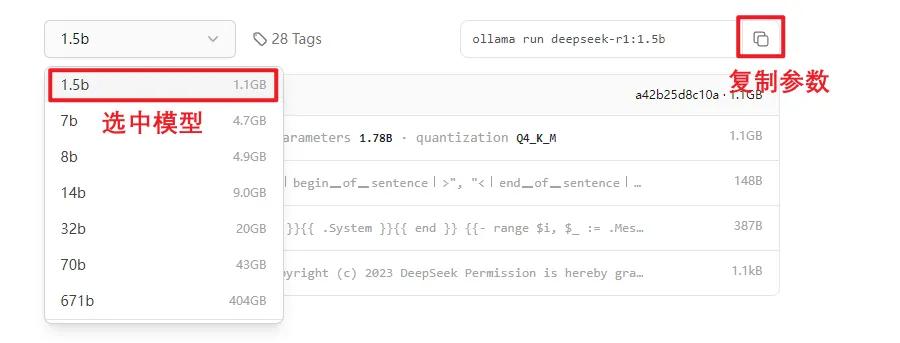

例如1.5b版本拥有15亿参数,内存要求相对较低(2G内存甚至核显也能跑),而更大参数的模型对内存要求自然水涨船高。

选中适宜你笔记本配置的版本(这儿以1.5b为例),复制页面中显示的命令。

Step3:安装模型

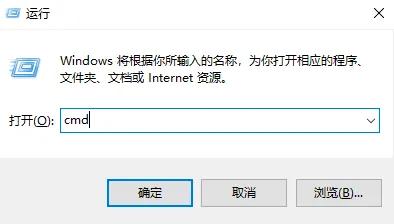

在Windows系统中,按下【Win+R】弹出如下窗口

输入【cmd】,点击【确定】,打开命令行。

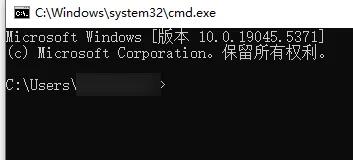

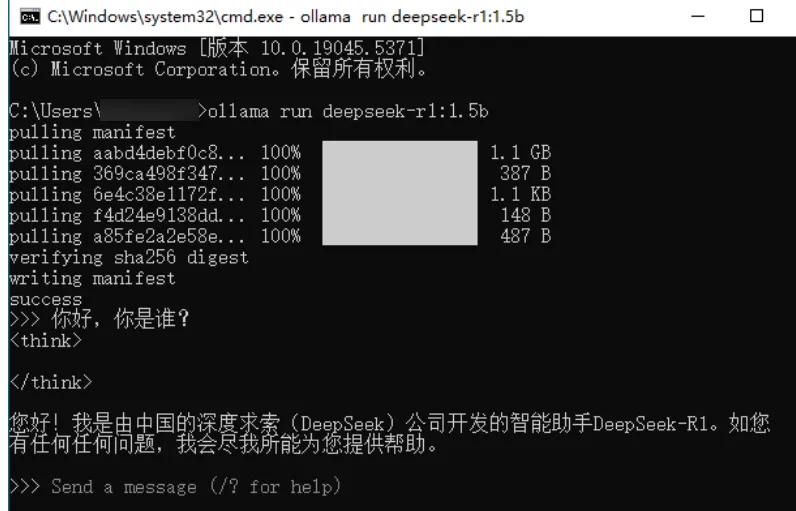

在命令行中粘贴刚刚复制的命令,按下回车键后,系统会手动开始下载模型。

等待下载完成即可。

下载过程中若发觉速率忽然变慢,试着关掉命令行再重新打开。

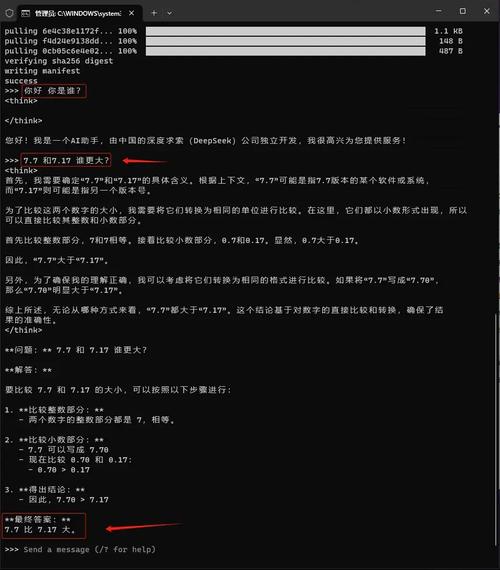

Step4:开始对话

下载完成后,你的笔记本就成功拥有了一个离线DeepSeek,即使断网也能使用。

此时,你可以直接在命令行里输入问题,与模型开始互动。

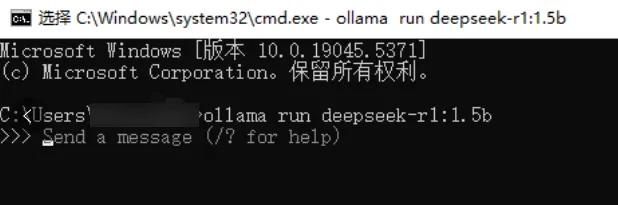

Step5:后续运行模型的小方法

每次死机后,上次想与DeepSeek聊天,你还得重复启动命令行,输入下载时的命令即可。

这一点要谨记:点击桌面的Ollama图标只是启动了软件,要想真正开始对话,还得用命令行来“喊话”。

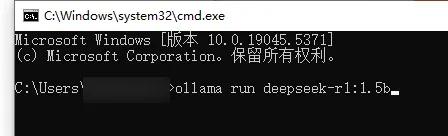

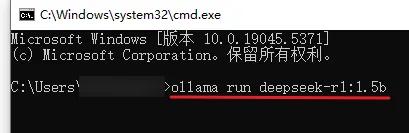

再度按下【Win+R】,在弹出的窗口里输入【cmd】,点击【确定】打开命令行。

在命令行界面,输入刚才的命令【ollamarundeepseek-r1:1.5b】,即可开始对话。

假如你不习惯在命令行窗口上面对话,或则希望有个更美观的交互界面,可以考虑安装Open-WebUI。

不过这不是必须的,不熟悉笔记本操作的男子伴可以暂时跳过。

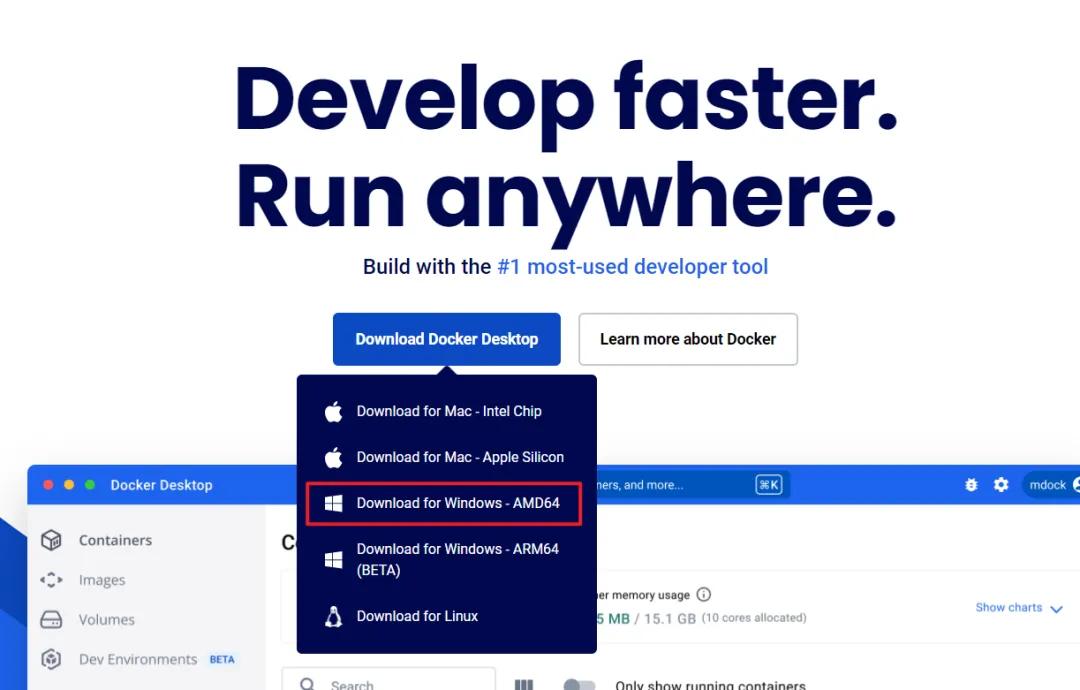

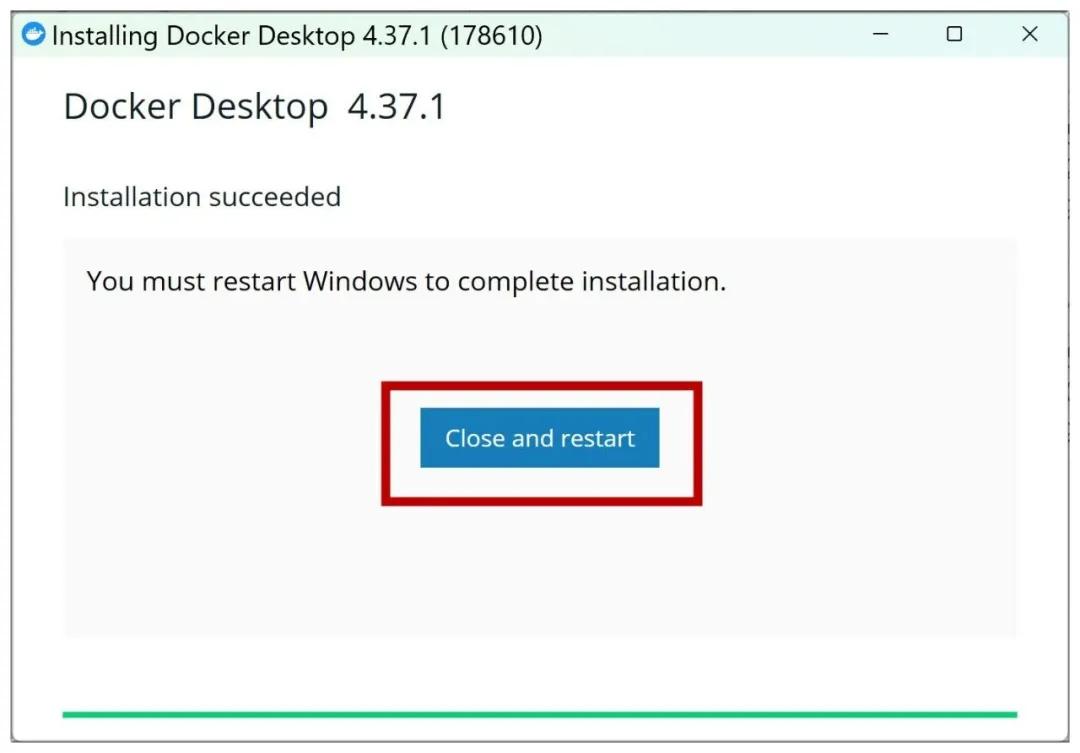

Step6:安装Docker

首先安装Docker。

步入官网(),下载并安装适用于你系统的Docker桌面版。

按步骤下载安装即可,安装完成后须要重启笔记本。

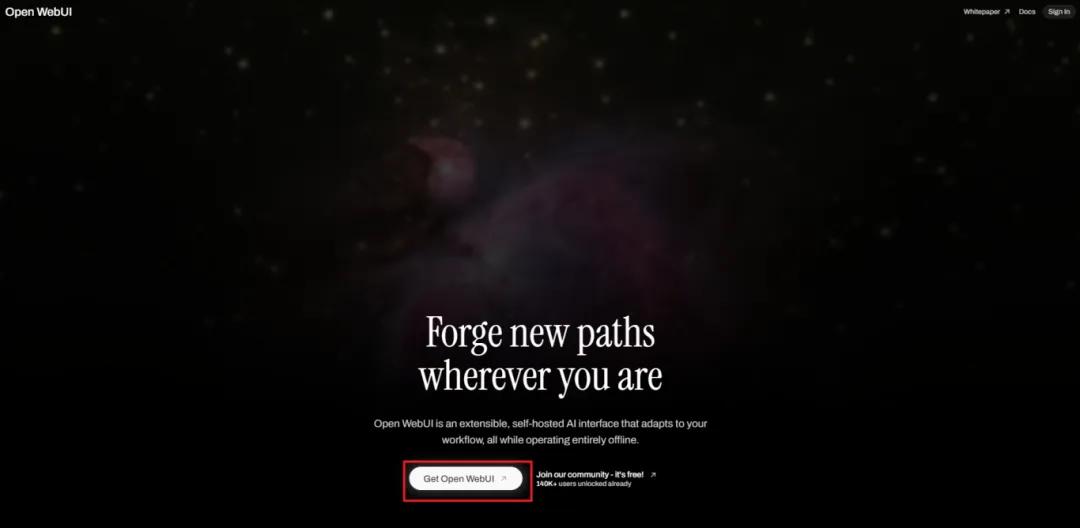

Step7:安装OpenWebUI

步入Open-WebUI官网()。

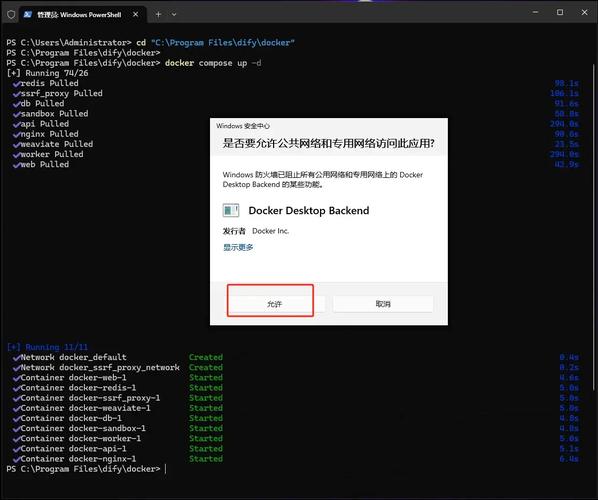

点击【GetOpenWebUI】,来到OpenWebUI的代码页。

下降找到【IfOllamaisonyourcomputer,usethiscommand】,点击左侧按键复制这个指令。

再度打开命令窗口,粘贴复制的命令,安装OpenWebUI即可。

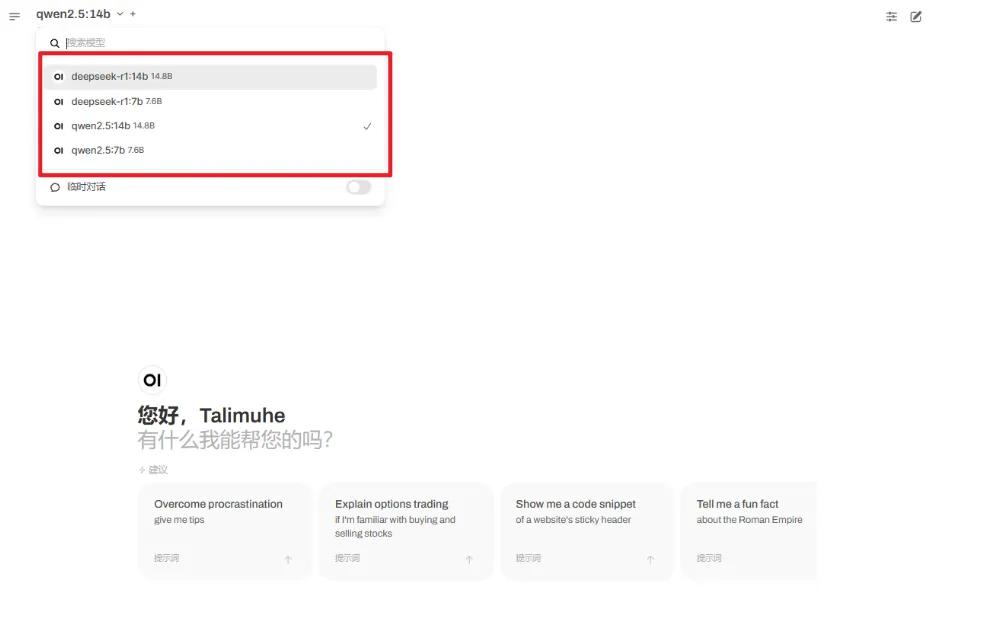

Step8:运行OpenWebUI

安装完成后RED HAT LINUX 9.0,双击桌面上的Docker图标启动Docker,再点击图片里框选的端口,即可运行Open-WebUI。

接着点击左上角,选择模型,就可以开始对话啦。

注意事项:一定要进行本地布署吗?

本地布署听上去拉风,但并不是所有人都适用。

假如你使用AI的频度并不高,这么直接下载DeepSeekAPP或使用网页版,显然是更好的选择,由于它们使用上去更便捷。

布署DeepSeek到本地笔记本主要适用于以下情况

1.硬件条件充足

笔记本配置较高,尤其是拥有独立显存,才能满足较大模型的内存要求。

2.数据安全需求高

须要处理敏感或私密数据,不希望数据上传至云端。

3.高频调用任务

日常使用频度较高且调用API会形成较高成本linux视频教程,本地布署可以减少费用。

4.个性化订制需求

希望在开源模型基础上进行二次开发或订制调整w3c linux,满足特殊业务需求。

通过本地布署,男子伴们可以更好地保障数据安全、降低使用成本并实现多样化需求,如有须要,按着教程步骤试试吧~