容器技术为应用部署带来了革命性便利,但许多开发者和运维人员发现,在享受Docker带来的环境一致性、资源隔离等好处时,应用的性能表现有时并不如直接运行在物理机或虚拟机上。这种性能上的折损并非空穴来风,它根植于容器化技术的底层原理。本文将深入探讨Docker性能损失的主要来源、具体表现以及如何有效进行优化,帮助你在效率与性能之间找到最佳平衡点。

Docker性能损失的主要原因是什么

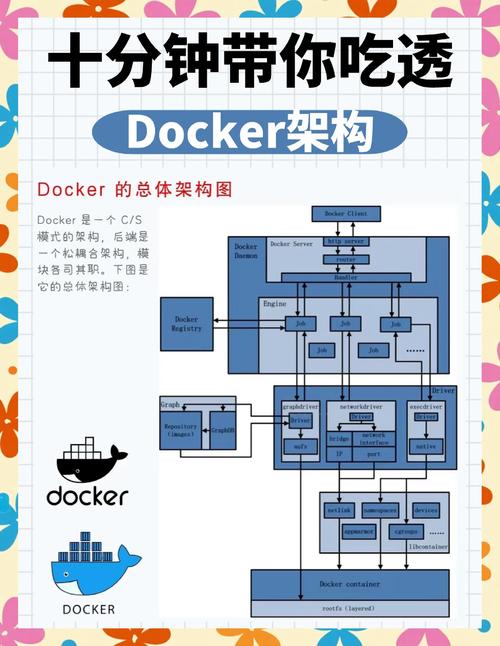

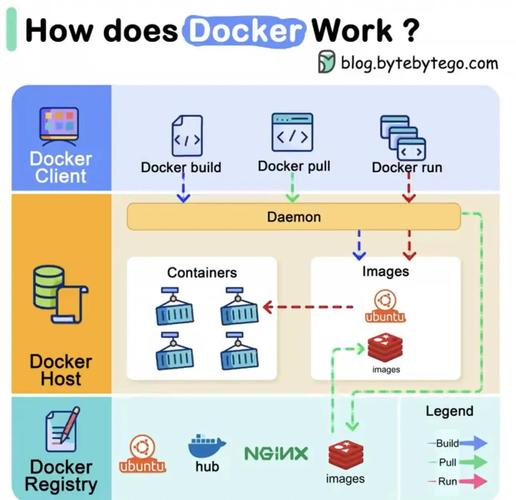

Docker性能损失的核心在于其架构带来的额外开销。与直接在宿主机操作系统上运行进程不同,Docker容器通过Docker引擎(守护进程)与内核交互,这一层抽象本身就会消耗少量的CPU和内存资源。虽然容器共享宿主机的内核,避免了传统虚拟机(VM)模拟完整操作系统的巨大开销,但每个容器独立的文件系统、网络栈和进程空间的管理仍需成本。例如,联合文件系统(如OverlayFS)在多层镜像叠加时docker 性能损失,会引入写操作放大的问题,影响I/O性能。

Namespace和Cgroup这两大基石技术也非零成本。Namespace为容器提供隔离,Cgroup用于限制资源,系统需要持续维护这些隔离边界和资源配额。在高密度部署场景下,大量容器的创建、销毁和调度会给宿主机内核带来压力,尤其是在网络和存储I/O方面,数据包或数据块需要经过更多的处理路径,从而导致延迟增加和吞吐量下降。

如何评估Docker容器的CPU性能损失

评估CPU性能损失,最直接的方法是使用docker stats命令观察容器运行时的CPU使用率,并与宿主机上同等负载的直接进程进行对比。你可能会发现docker 性能损失,容器化应用的CPU使用率会略高,这主要源于Docker守护进程的管理开销以及Cgroup配额管理本身的消耗。对于计算密集型应用,这种损失通常比较微小,可能仅在1%-5%之间,但在极端情况下,如频繁的系统调用,损失会加剧。

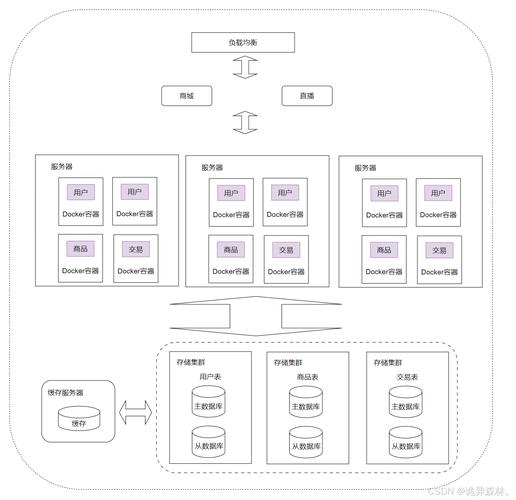

进行压测是更精确的手段。你可以使用sysbench或stress工具同时在容器内和宿主机上施加相同的CPU负载,然后对比完成计算任务所需的时间。需要注意的是,容器本身的启动和资源调度也会占用CPU时间。在微服务架构中,当大量容器实例同时被调度器(如Kubernetes)频繁启停或伸缩时,整体集群的CPU资源利用率会因这些管理操作而降低,这属于间接的性能损失。

Docker对内存使用效率有何影响

Docker对内存的影响主要体现在两个方面:基础内存开销和内存限制带来的影响。每个运行的容器都会占用一部分额外的内存,用于维护其内核数据结构、网络栈和缓存等。虽然单个容器的开销很小(可能仅几MB),但在运行成百上千个容器时,累积的内存消耗就不可忽视了。另外,容器镜像的分层结构会导致内存中可能存在多份相似的文件页副本,影响内存使用效率。

更关键的影响来自内存限制(Cgroup memory limit)。当容器内进程的内存使用量接近设定的上限时,内核会开始频繁地进行内存回收,甚至触发OOM Killer(内存不足杀手)终止容器内进程,导致服务中断。即使没有达到极限,过于严格的内存限制也会使应用内部的缓存(如JVM堆缓存、数据库缓存)无法充分施展,从而被迫增加磁盘I/O,间接拉低整体性能。合理设置内存限制并监控实际使用情况至关重要。

Docker容器磁盘IO性能如何优化

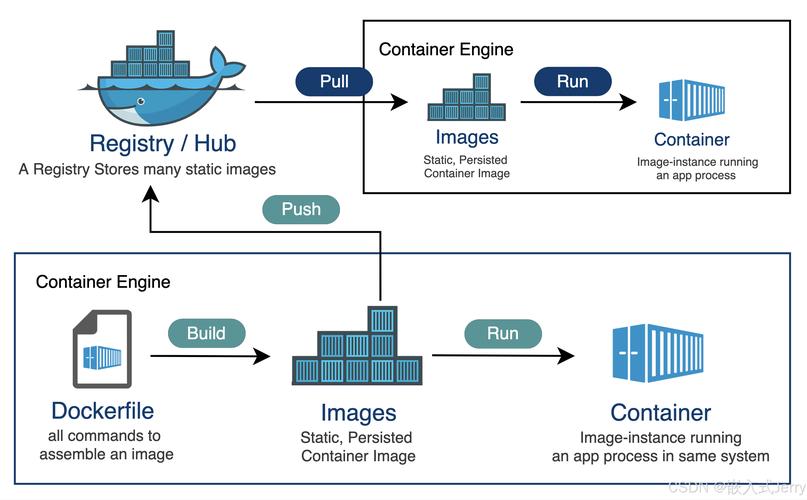

磁盘I/O是Docker性能的常见瓶颈。默认使用的存储驱动(如Overlay2)虽然节省了磁盘空间,但写操作需要经过多层叠加,性能通常不如直接写入宿主机文件系统。对于I/O敏感型应用linux操作系统介绍,一个有效的优化方法是使用volumes(数据卷)。数据卷绕过了存储驱动,直接挂载宿主机目录到容器中,能显著提升读写速度,特别是对于数据库等需要持久化大量数据的应用。

另一个优化方向是根据 workload 类型选择存储驱动。对于写操作繁重的场景,devicemapper驱动在direct-lvm模式下可能表现更好。此外,使用高性能的固态硬盘(SSD)作为宿主机存储基础是根本性提升。在配置层面,可以通过--blkio-weight参数为容器设置I/O权重,或在启动时使用--device-read-bps等选项限制其磁盘带宽,避免个别容器耗尽I/O资源,影响其他邻居容器的性能。

Docker网络性能损失大吗

Docker容器的网络性能损失程度取决于所使用的网络模式。默认的bridge模式会为每个容器创建虚拟网卡(veth pair),并通过一个Linux网桥(docker0)进行通信,数据包需要经过网桥的转发和处理,这会引入少量的延迟和CPU开销。在需要极低延迟和高吞吐量的场景下,这种开销可能变得显著。例如,相比宿主机本机通信,容器间通过网桥通信的延迟可能会增加数十微秒。

为了追求极致性能,可以考虑使用host网络模式。在此模式下,容器直接共享宿主机的网络命名空间,使用宿主机IP,完全绕过了Docker的网络虚拟化层,性能损失最小,几乎与原生性能无异。但代价是失去了端口隔离的灵活性,存在端口冲突的风险。对于容器与外部网络的通信,优化宿主机物理网卡和网络配置(如开启巨帧)带来的收益,远大于优化Docker网络本身。

如何全面监控和调优Docker性能

全面的监控是性能调优的基础。除了基础的docker stats命令linux命令行,建议集成更强大的监控工具,如cAdvisor(Container Advisor),它能提供容器资源使用情况的详细图表。结合Prometheus和Grafana可以构建可视化的监控仪表盘,实时追踪CPU、内存、网络和磁盘I/O等关键指标。通过历史数据对比,你能清晰发现性能瓶颈的变化趋势。

调优是一个持续的过程。首先,确保宿主机内核和Docker版本保持最新,以获取最新的性能优化。其次,根据应用特性调整容器配置:计算密集型应用可设置CPU共享(--cpu-shares)或绑定CPU核心(--cpuset-cpus);内存敏感型应用需合理设置-m限制并留有余量。最后,审视整个应用架构,例如,是否可以通过减少不必要的容器数量、优化镜像层数、使用更轻量的基础镜像(如Alpine Linux)来从根本上降低资源开销。

在容器化的道路上,你是否也遇到过令人头疼的性能问题?是哪个环节的损耗最大?欢迎在评论区分享你的实战经验和调优技巧,如果觉得本文有帮助,请不吝点赞和分享!