日常工作中,我们经常遇到日志文件过大、数据集需要拆分、或者要把一个大文件分成几个小块的场景。Linux命令行提供了非常成熟、灵活的分割工具,不需要安装额外软件就能完成这些任务。本文将围绕最实用的操作场景,详细讲解Linux下分割文件的常用方法、参数调优以及典型应用案例。

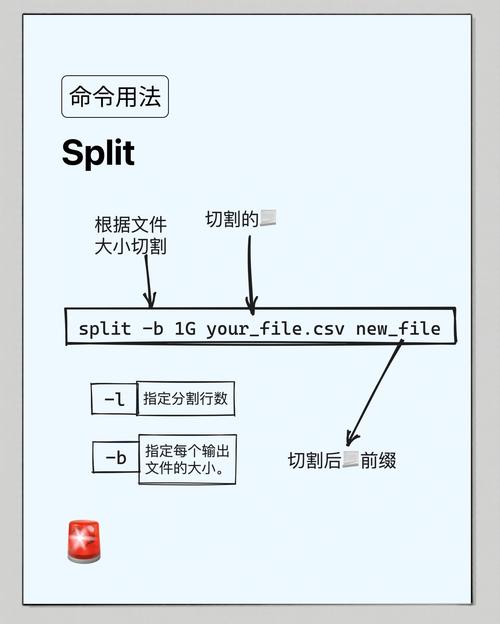

怎么按大小分割文件

按文件体积拆分是最常见的需求。Linux的split命令默认就是以字节数为单位进行切割。比如要把一个1GB的日志文件切成200MB一块,可以使用split -b 200M biglog.log part_。这里的-b参数指定每个小文件的大小,支持K、M、G等单位。命令执行后,会生成part_aa、part_ab、part_ac等一系列文件,默认命名规则是两位字母递增。

实际操作中要注意单位换算。split使用的是二进制前缀,1M等于1048576字节,而不是1000000。如果你需要严格按100MB十进制拆分,可以用-b 104857600来精确控制。对于文本文件,split默认按字节切割,不会破坏行结构,可能把一行内容切到两个文件里。如果希望以完整行为单位拆分,要用-b配合-l参数,或者直接用行数拆分。

怎么按行数分割文件

文本处理时按行拆分往往更实用。split -l 1000 access.log log_part_就能把access.log每1000行切成一个新文件。这个场景在分析Web日志时非常常用——你需要把几千万行的日志分批次导入数据库,或者分发给多个同事并行排查。

行数拆分有一个容易被忽略的技巧:如果文件最后不足指定行数,split会自动把剩余行放到最后一个文件里,不会报错也不会丢失数据。另外,大文件拆分时建议先用wc -l查看总行数,估算一下会生成多少个小文件。如果小文件数量超过676个(aa到zz),split默认的两位后缀会不够用,这时需要加-d参数使用数字后缀,并用-a指定后缀长度,比如split -l 10000 -d -a 3 bigfile.txt part_会生成part_000、part_001等文件。

分割后怎么合并回去

分割本身不是目的,后续往往需要恢复原文件。合并操作极其简单:cat part_<strong> > restored_file。这里的关键是必须保证合并顺序正确。cat默认按文件名排序拼接,而split默认生成的aa、ab、ac顺序就是正确的。如果你用了数字后缀,排序规则依然是字典序,001、002、010这样的命名没问题,但如果你用了001、002、003,文件名长度一致,字典序就等于数字序。

有个实际坑点:如果你在Windows系统生成了分割文件,传到Linux后文件名排序可能不同。Windows资源管理器的排序与Linux不完全一致。稳妥做法是合并前用ls -v查看排序,-v参数能按版本号自然排序linux入门,或者直接用cat $(ls -v part_</strong>)来合并。对于压缩包的分割,合并后建议用md5sum或sha256sum校验文件完整性,与原文件的哈希值对比。

分割时怎么自定义文件名

split默认的输出文件名是xaa、xab这种风格,既不直观也不方便管理。通过指定前缀可以解决这个问题:split -l 5000 huge_data.csv data_chunk_会生成data_chunk_aa、data_chunk_ab等文件。前缀甚至可以包含路径,比如split -b 50M large.bin /tmp/backup/slice_直接把分割文件写到/tmp/backup目录下。

后缀格式也能自定义。--additional-suffix参数可以为每个输出文件添加扩展名,比如split -b 10M --additional-suffix=.txt data.txt chunk_会得到chunk_aa.txt、chunk_ab.txt。这个功能在处理特定格式文件时很实用,生成的碎片文件直接双击就能用默认程序打开。配合-d使用数字后缀,加上自定义扩展名,是最接近Windows分卷压缩体验的做法。

怎么用csplit按内容分割

split只能按大小或行数机械分割,而csplit可以根据文件内容或上下文逻辑来拆分。比如要把一个配置文件按每个章节分割,章节以“Chapter”开头,可以用csplit -z config.txt /Chapter/ '{<strong>}'。这里的/Chapter/是正则表达式,'{</strong>}'表示重复分割直到文件末尾,-z参数避免生成空文件。

另一个典型场景是拆分多记录文件。比如一个文本文件里每两条记录之间有空行,可以用csplit -z data.txt /^$/ '{*}'把每条记录单独存为一个文件。csplit还支持偏移量,比如/%start%/+1可以从匹配行的下一行开始切割。写脚本处理报表导出、日志清洗时,csplit往往比写Python或Perl脚本更直接,效率也更高。

大文件分割有哪些坑

第一个坑是磁盘空间不足。分割100GB文件至少需要100GB空闲空间,如果原文件删得晚,甚至会双倍占用。建议分割前用df -h检查目标目录的剩余空间,分割确认无误后再删除原文件。第二个坑是文件系统限制。FAT32单个文件最大4GB,如果你把4GB以上文件分割成3.9GB的碎片,传到移动硬盘可能写不进去,换exFAT或NTFS格式可解。

第三个坑是字符编码。split是字节级别的操作,对二进制文件完全没问题,但对文本文件,如果包含中文等多字节字符linux分割文件,按字节切割可能导致乱码。处理UTF-8编码的中文日志时,务必用-l按行分割,不要按-b字节切。第四个坑是权限和时间戳。分割生成的文件默认继承当前umask和当前时间linux命令tar,如果需要保留原文件的权限和修改时间,要用cp --preserve=timestamps先复制一份再切linux分割文件,或者用touch手动调整。

你在用split处理超大型文件时,遇到过最棘手的错误是什么?欢迎在评论区分享你的排坑经验,也别忘了把这篇干货转发给团队里经常处理日志的同事。